1. Bevezetés

A mesterséges intelligencia (MI) a korunkban felgyorsult technológiai fejlődés egyik legfontosabb és legizgalmasabb kihívását jelenti. Egyfelől – mint minden más technológiai fejlődés – csak úgy lehet értelmes, ha a társadalom javát szolgálja, ha az ember képességeit javítja. Másfelől komoly kockázatokat is rejt magában. Az MI mint technológia szabályozása – más technológiák szabályozásához hasonlóan – azzal a kötelezettséggel jár, hogy jólétnövelő hatások a kockázatok minimálisra szorításával álljanak elő. Az MI társadalom javát szolgáló elterjedése nemcsak szabályozási eszközöket igényel (pl. befektetés és kutatás-támogatás, szakemberképzés), de a kockázatok kiküszöbölésénél, a megbízhatóság erősítése kapcsán megkerülhetetlen. Kérdés az MI kapcsán, hogy a jog be tudja-e tölteni ezt a megbízhatóságerősítési szerepet egy olyan technológia vonatkozásában, amelynek alaptulajdonsága az átláthatatlanság, kiszámíthatatlanság, kiismerhetetlenség. 2015-ben például Stephen Hawking, Elon Musk és Bill Gates hívta fel arra figyelmet, hogy az MI a nukleáris fegyverkezésnél is nagyobb veszélyeket hordozhat magában és fenyegeti az emberiséget.[1] Az MI szabályozásának legfőbb paradoxonja tehát, hogy az ismeretlen technológiákkal kapcsolatos szabályozási alapvetés és a bizalmi elv miként egyeztethető össze az MI kapcsán, amely természeténél fogva bizalmatlanságot ébreszt. Az MI kapcsán egyfajta versenyhelyzet tapasztalható a világ vezető gazdaságai között. Ez adott esetben a technológiák szabályozásában élen járó EU esetében azzal a veszéllyel járhat, hogy megfontolt technológiaszabályozási megközelítéseiből esetleg emiatt felad. A kérdés konkrétan az elővigyázatosság technológiaszabályozási elvére vonatkozik, amely az ismeretlen hatású technológiák esetében a teljes tiltást is alkalmazhatónak tartja, ha a kockázatok magasak és súlyosak lehetnek (lásd pl. génmódosított növények).

Jelen tanulmányban elsősorban erre keresem a választ az MI megfelelő működésének olyan jogi vonatkozásai mellett, mint az egységes európai adattér létrehozása vagy a károsultak kompenzálásának elvét és az innováció védelmét is tiszteletben tartó kárfelelősségi és termékfelelősségi szabályok kialakítása.

2. A mesterséges intelligencia fogalma

A mesterséges intelligencia fogalmának meghatározásánál nem mesterségesség, hanem az intelligencia okozza a fő problémát, mert egyből emberi tulajdonságokat (tudatosság, öntudat, nyelvezet, tanulási képesség, elvonatkoztatási képesség, alkalmazkodás) kapcsolunk hozzá.[2] Stuart Russell és Peter Norvig az MI négy kategóriáját említi: emberi módon való gondolkodás, emberi módon történő cselekvés, racionális gondolkodás és racionális cselekvés.[3] Turing ezzel szemben nem a humán gondolkodási folyamat helyettesítésére, hanem ezen folyamat külső megjelenítésére helyezi a hangsúlyt.[4] Ez egyfajta tettetés, ahol a gép megpróbálja meggyőzni az embert, hogy ő valójában nem is gép.

Jelenleg a legelterjedtebb megközelítés az MI fogalmának meghatározására Russell és Norvig racionális cselekvéséből indul ki és arra fókuszál, hogy az MI az a gép, amely meghatározott cél elérésén dolgozik.[5] Ebből indul ki a mesterséges intelligencia EU bizottsági definíciója is, amely szerint az intelligens viselkedésre utaló rendszereket takar, amelyek konkrét célok eléréséhez elemzik a környezetüket és – bizonyos mértékű autonómiával – intézkedéseket hajtanak végre.[6] A mesterséges intelligencián alapuló rendszerek lehetnek kizárólag szoftveralapú rendszerek, amelyek a virtuális világban működnek (pl. hangasszisztensek, képelemző szoftverek, keresőprogramok, hang- és arcfelismerő rendszerek), illetve a mesterséges intelligencia beépíthető hardvereszközökbe is (pl. fejlett robotok, autonóm járművek, drónok és a tárgyak internetéhez kapcsolódó alkalmazások).[7] A mesterséges intelligencia átfogó fogalom, amelynek körén belül az egyik legjelentősebb terület a robotika, amely magában foglal mesterséges intelligenciát, továbbá fizikai megjelenés is jellemzi.[8]

3. Az MI közpolitikai megközelítései

A technológiai fejlődés mögött mindig valós társadalmi igények húzódnak meg: az egyszerűbb, gyorsabb, hatékonyabb, eredményes megoldások iránti emberi szükségletek. Az új technológiák hozzájárulhatnak a termelőeszközök hatékonyabb kihasználásához, a kereslet és kínálat hatékonyabb összekapcsolásához.[9] Ezen túl az új technológiák olyan iparágakra is innovációs hatást gyakorolhatnak, amelyek jellegüket, természetüket tekintve (nem feltétlenül gazdasági értelemben) már évtizedek óta stagnálás jegyeit mutatják (pl. taxi).[10]

Az MI-nek is csak úgy van értelme, ha az emberek javát szolgálja, és ha fokozza az emberek képességeit.[11] Az MI jelentette előnyöket az EU Bizottság Fehér Könyve három kategóriába sorolja:[12] (i) polgárok: javíthatja az egészségügyi ellátást, biztonságosabbá teheti a gépjárműveket; (ii) az üzleti élet: lehetővé teheti a mezőgazdasági termelők számára a természeti erőforrások hatékonyabb felhasználását; (iii) közszféra: segíthet a csalás és a kiberbiztonsági fenyegetések észlelésében, a bűnüldöző hatóságok számára a bűnözés elleni hatékonyabb fellépésben.[13] Az MI azonban kockázatokkal is jár: a nem világos döntéshozatali folyamatból, az esetleges diszkriminációból és az illetéktelen kezekbe kerülés miatti fenyegetettségből fakadóan.1[14] Az algoritmusok nem teljes – és ezért nem megbízható – adatok alapján is hozhatnak döntéseket, kibertámadás célpontjaivá válhatnak, döntéseik pedig torzulhatnak, vagy egyszerűen tévesek lehetnek.[15] Az MI által okozható károk lehetnek anyagiak (biztonság, egészség, dologi vagy emberi életben eső kár), immateriálisak (magánszféra sérelme, a véleménynyilvánítás szabadságát ért sérelmek, diszkrimináció). Amennyiben az MI működése az emberi élet olyan meghatározó területeire is kiterjed, mint a közlekedés (pl. önvezető autók) vagy egészségügy (pl. diagnosztika), akkor az MI nem megfelelő működése nemcsak anyagi javakat, de adott esetben emberi életet is veszélyeztethet.

Az MI elterjedése kapcsán ki kell emelni, hogy az Amerikai Egyesült Államokban (USA) a nagyvállalatok jelentős összegeket fektetnek az MI fejlesztésébe, az észak-amerikai (12,1–18,6 milliárd EUR) beruházások szintje mögött azonban az európai magánberuházások értéke e téren (összesen 2,4–3,2 milliárd EUR 2016-ban) jelentősen elmarad.[16] Az EU a következő évtizedre évi 20 milliárd EUR éves beruházási célkitűzést irányzott elő.[17]

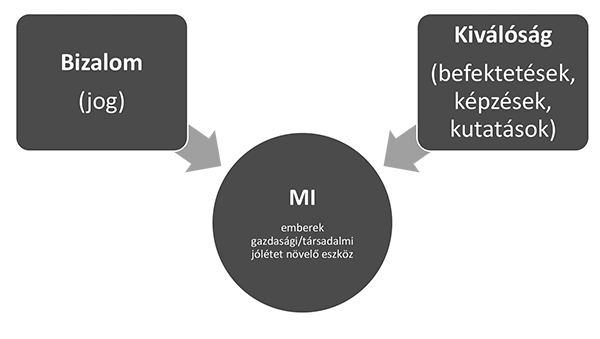

Fentiek fényében kettős szabályozói megközelítést fogadott el az EU Fehér Könyvében: egyszerre bizalom- és befektetésorientált a társadalmi jólét és gazdasági növekedés érdekében.[18]

4. A paradoxon: a szabályozás helye az MI társadalom javát szolgáló elterjedésében

Ha elfogadjuk, hogy az MI nem maga a cél, hanem egy, az embereket szolgáló eszköz, melynek végső célja az emberi jólét növelése (nem az emberek helyettesítése, hanem az emberi képességek javítása), akkor szükség van olyan biztosítékokra, amelyek az MI ilyen irányú hasznosulását, fejlődését biztosítják. Ilyen eszközök az MI alapú befektetések fokozása, a társadalom egészének a felkészítése, az alapszintű digitális készségek erősítése, a szakemberképzés, a munkahelyüket elvesztők támogatása[19] és maga a szabályozás is.[20] A szabályozás is tehát csak egy eszköz, hogy az MI a társadalom javát szolgálja. Ennek megvalósítása érdekében gondoskodni kell arról, hogy a mesterséges intelligencia megbízható legyen.

Annak érdekében, hogy az MI betölthesse az emberek javát szolgáló célját, bizalmat kell ébreszteni iránta, ezért az MI-nek az értékeinken, az alapvető jogokon, az emberi méltóságon és a magánszféra védelmén kell alapulnia (lásd a 3. pontban MI kapcsán említett veszélyeket). Ebből a szempontból pedig a jogi szabályozásnak kulcsszerepe lehet, ugyanakkor a bevezetőben jeleztem, hogy az MI szabályozásának legfőbb paradoxona abból fakad, hogy miként lehet egy fogalmilag bizalmatlanságot ébresztő technológiával kapcsolatosan bizalomerősítésről beszélni. A technológiai fejlődéshez nyilván annak szabályozása is hozzátartozik, és abban az EU élen kíván járni.[21] Az EU egységes szabályozási kezelésben érdekelt az MI egységes belső piaca fejlesztése érdekében, azért, hogy az EU az MI terén is versenyképes maradjon világszerte, miközben biztosítja polgárai jólétét.[22] Kérdés, hogy az EU a versenyképesség érdekében nem hoz-e az MI-vel kapcsolatban túl nagy kockázattal járó áldozatot.

5. A megbízhatóság mint az ismeretlen technológiaszabályozás vezérelve

A megbízhatóság kapcsán érdemes egy pillanatra megállni és tágabb kitekintést tenni a technológiák szabályozási kihívásaira. Szabályozási szempontból ugyanis a technológiák két típusát különböztethetjük meg: az egyik, amikor a technológia felforgatja az addigi gazdasági, társadalmi viszonyokat (romboló technológiák).

A romboló technológiák nem hoznak létre új piacokat, hanem a hagyományos piacokon jelennek meg és támasztanak komoly kihívásokat. Erre jó példa a megosztás alapú gazdaság platformjai (pl. Uber, Airbnb). Ezek kapcsán mindig az kérdés, hogy a hatályos szabályok mennyiben alkalmazhatók és értelmezhetők az új, innovatív piaci szolgáltatásokra és hogy a szabályozás ne hozzon létre versenyelőnyt, illetve versenyhátrányt. A romboló technológiák szabályozásakor nem kell megküzdeni az ismeretlenség jelentette kihívásokkal és a tiltás csak végső esetben merül fel.[23]

A technológiák szabályozási szempontból másik nagy kategóriája, amikor a technológiának valamilyen addig nem ismert és jövőre nézve is nehezen megragadható jellemzője van.[24] Az MI ez utóbbi körbe tartozik, hiszen alapvető jellemzője, hogy sokkal rövidebb idő alatt sokkal több információ feldolgozására képes, mint az emberi agy, ezáltal olyan lehetőségeket is figyelembe tud venni, amelyekkel az ember esetleg nem is számolt. Vagyis az MI működésének eredményei adott esetben még az őt tervező ember számára is sem előre láthatók (black box effect).[25] Miközben az ismeretlen technológiák (mint amilyen az MI) szabályozási kezelése középpontjában a megbízhatóságnak és biztonságnak kell fókuszban lenni, az MI kapcsán felmerülő black box hatás miatt szabályozási paradoxonról beszélhetünk abban az értelemben, hogy miként lehet jogi eszközzel egy fogalmilag bizalmatlanságot ébresztő technológia kapcsán a bizalom erősítéséről beszélni, amely az ismeretlen technológiák szabályozási vezérelve. Alábbiakban ennek a paradoxonnak a feloldására teszek kísérletet.

Az ismeret hiánya Mandel szerint a technológia szabályozásának legfőbb kihívása, hiszen erre vezethető vissza a technológia társadalmi elutasítottsága, az emberek félelme, a szabályozói bizonytalanság és ezáltal a befektetői környezet kiszámíthatatlansága.[26] Az emberek félelme és technológiákkal szembeni elutasítása kapcsán beszél Tranter a Frankenstein-mítoszról, amely mögött a társadalmi kontextust nem ismerő, saját találmánya iránt mélyen elfogult tudós képe húzódik meg.[27]

Nyugaton például robotokkal (amelyek az MI alkategóriáját képezik) kapcsolatosan történelmileg is léteznek a negatív társadalmi előítélek, amelyeket az ember kreálmánya feletti hatalom elvesztésétől való félelem táplál.[28] Nyugaton ezek az előítéletek azonban nemcsak történelmileg, de a jelenben is léteznek: Asimovnak egyébként elege volt ebből a nyugati előítéletességből a robotokkal kapcsolatban és nem abból indult ki, hogy a robot mindenképpen csak alkotója elpusztítója lehet.

Az ismeretlen technológiák a joggal szemben kettős elvárást támasztanak: egyrészről biztosítani kell, hogy a technológiai fejlődés ne ássa alá az emberi szabadságjogokat. Másfelől szükséges azonban az is, hogy a jog ne korlátozza a technológiai fejlődést. Az Európai Parlament szerint is egy robotokra vonatkozó európai szabályozás segíthet annak tudatosításában, hogy a robotok immár nem a sci-fi világába tartoznak.[29]

Az ismeretlen technológiára adott felelős jogi válasz kulcsa egy olyan alapállás, amely a kockázatokat nem pusztán feltételezi, hanem azok létéről tudományos alapon meggyőződik (precaution principle).[30]

Az elővigyázatosság elve egyik szélsőséges értelmezése, hogy az ismeretlen technológia blokkolható addig, amíg nem bizonyosodik be róla, hogy biztonságos.[31] Erre jó példa az az eset, amikor a Pfizer állatoknak szánt antibiotikumát az EU-ban arra való hivatkozással tiltották be, hogy nem lehetett teljes tudományos bizonyosságot nyerni arra vonatkozóan, hogy a szer emberekben nem hoz létre antibiotikumrezisztenciát.[32] A kockázatbecslésnek tudományos alapokon és nem a közvélemény félelmén kell alapulnia. Ez utóbbi történt a növekedési hormonnal kezelt marhák húsának európai tilalma kapcsán, amikor AG Lenz az ilyen húsok széles körű társadalmi elutasítottságára hivatkozva érvelt a tiltás mellett a fogyasztók érdekében.[33] Az Alaptörvény XX. cikkének (2) bekezdésében kifejezetten utal arra, hogy Magyarország a testi és lelki egészséghez való jogot egyebek között a genetikailag módosított élőlényektől mentes mezőgazdaság révén kívánja megvédeni. Ez világos rendelkezést jelent az idegen fajok génjeinek beépítésével létrehozott, genetikailag módosított növények esetében (GMO), amelyek súlyos kockázatokat vetnek fel. Kérdés, mi a helyzet az ún. génszerkesztési módszerekkel, ahol az idegen gének a módosítás folyamatában csak átmenetileg kerülnek be a génállományba. Tehát nem tekinthető egyértelműen génmódosításnak. Kérdés: lehet-e kiterejsztően értelmezni az Alaptörvény génmódosításra vonatkozó kitételét és abba a gén szerkesztését is bele kell-e érteni. Miután egyelőre nincsen közegészségügyi, környezetvédelmi szakmai konszenzus a gén szerkesztés következményeit illetően, ezért az elővigyázatosság elvének figyelembevételével génmódosításnak kell tekinteni és szintén tilalom alá kell essen.

Ugyanakkor a társadalomnak le kell mondani arról az illúzióról, hogy mindenféle technológiai kockázat előre felmérhető és pusztán szabályozással megelőzhető. A vegyipari balesetek megelőző szabályozási doktrínája, az ún. Seveso irányelv alapján is világos, hogy pusztán a múltban bekövetkezett balesetek tanulságai nem óvhatják meg a társadalmat, önmagukban nem garantálhatják a biztonságos jövőt.[34] Így az elővigyázatosság elvének lényegét valójában helyesebb egyfajta kockázatértékelő szabályozási hozzáállásban keresni, amelybe a tiltás csak akkor férhet bele, ha a tudományos szempontok szerint azonosított magas kockázat más szabályozási eszközzel megnyugtatóan (biztonságosan) nem küszöbölhető ki. Valójában tehát a fentiek szerint értelmezett elővigyázatosság elvét ki kell egészíteni: nem elegendő a tiltáshoz, hogy a tudományos bizonyítékok fényében az adott technológiáról nem tudjuk biztonságos-e; szükséges az is, hogy a kockázatok szabályozási elvárásokkal nem szoríthatók le egy még vállalható szintre. A tudományosan igazolt kockázatok szabályozási kezelése kapcsán észre kell venni, hogy a technológiai haladás és a válaszadásra késztetett jog között van egy fontos összefüggés, amely a jogot megfelelő válaszok kialakításában segítheti: a szabályozás maga is technológia, a kormányzás technológiája.[35] A technológiai fejlődés szabályozása így nem más, mint a szabályozás technológiájának kérdése. A szabályozásnak is számos technológiája, eszköze van.

A megbízhatóság megteremtése, a kockázatok felmérése és szabályozási kezelése szempontjából meghatározó szerepe van az etikai elveknek.

Az etikai elveket tehát az emberi méltóság támasztja alá, a jogi keretrendszer finomhangolását segítik, azt mutatják meg, hogy milyen irányba kell a szabályozást kialakítani.[36] Az EP is hangsúlyozza, hogy mindennemű robotetika központi elemének a sérthetetlen emberi méltóságnak kell lennie.[37] Asimov robottörvényeinek középpontjában is az ember védelme áll, nevezetesen, hogy a robot nem okozhat kárt az emberiségnek és az egyes embernek. Úgyszintén a robotnak tiszteletben kell tartania az ember döntéshozatali szabadságát, amely az emberi méltóság sérthetetlenségéből fakad.[38] Meg kell különböztetni a robotetikát a gépek etikájától vagy másként robotjogtól[39] előbbi a robotok tervezőire, gyártóira, működtetőire vonatkozik, utóbbi pedig magukra a robotokra.[40] Miután még az autonóm robotok sem képesek morális döntésekre, így a gépi etika (robotjog) egyelőre hipotetikus. Asimov törvényei a robotokra vonatkoznak, de erre figyelemmel azokat a robotok tervezőire, gyártóira kell adaptálni.

Az MI az embert segítő működése során számos személyes és különös érzékeny adat birtokába kerülhet, amelyek bizalmasságát biztosítani kell és robot általi kezelésüknek mindenkor a robot használó ember kifejezett hozzájárulásán kell alapulnia.[41]

Az MI szabályozásának általános kialakítása kapcsán három fő etikai irányt kell kiemelni:

- emberi autonómia tiszteletben tartása: ne irányítsa/manipulálja az embert, demokratikus folyamatokat ne veszélyeztesse;

- kár megelőzése: ideértve a kár bekövetkezését eredményező nem kívánt külső behatásoknak való ellenállást;

- magyarázhatóság: a működés transzparenciája.

6. Az MI szabályozási paradoxonjának egy lehetséges feloldása

Az MI egyik kihívást jelentő fontos jellemzője az előreláthatóság fogalmához kapcsolódik.[42] Alapvető különbség az emberek és az MI a döntéshozatali folyamata között, hogy az emberi agy kognitív korlátoktól terhes azáltal, hogy nem képes elemezni az összes információt, vagy a rendelkezésre álló információkat a rendelkezésre álló időkeretben. Ezért az emberek gyakran az optimális megoldás helyett kielégítő megoldás megtalálására törekszenek.[43] Az MI ezzel szemben sokkal több lehetőséget tud áttekinti egy adott időtartamon keresztül, mint egy ember, ezáltal olyan lehetőségeket is figyelembe tud venni, amelyekkel az ember esetleg nem is számolt. Ebből fakad az MI már hivatkozott fekete doboz hatása, vagyis amikor az MI még a tervezői számára is meglepő vagy akár nem is értelmezhető eredménnyel áll elő.

Az EU erre figyelemmel olyan új MI-specifikus szabályozás megalkotásában érdekelt, amely egyszerre hatékony és nem túl korlátozó az MI terjedését illetően.[44] Ennek érdekében kockázat alapú megközelítést irányoz elő, amely értékelhető a fentiek szerinti kiegészített elővigyázatosság elvének való megfeleléseként. A kockázatokat szektorális szempontok (pl. egészségügy, közlekedés, energetika, közigazgatás) és a szándékolt használat alapján felmerülő kockázatok (pl. biztonság, fogyasztói jogok, alapvető jogok) alapján kellene felmérni.[45] A Bizottság a magas kockázatú MI-k esetében előzetes megfelelőség-ellenőrzést tartana szükségesnek a szabályozási elvárásoknak megfelelés szempontjából már a fejlesztés fázisában az algoritmusra és adatokra is kiterjedően.[46] Mindez nem érintené az MI működésnek ex-post felügyeletét. Ezért az MI működésével összefüggő adatokat meg kell őrizni, hogy utóbb visszakereshető, ellenőrizhető legyen.[47] Ezen túlmenően szükséges biztosíték, hogy az MI ember által felügyelt maradjon. Ebből következik, hogy az MI működésének eredményét az embernek jóvá kell hagynia vagy biztosítani kell, hogy emberi közbeavatkozással a folyamat megszakítható és visszafordítható legyen.[48] Az MI működése közben is szükség van arra, hogy menet közben az ember beavatkozhasson, ha szükséges.

Teljes megnyugtató eredményt természetesen a teljes tiltás hozhatna, de egyrészt fel kell adni, hogy van 100%-os biztonság, másfelől az MI kapcsán a társadalmi előnyök is kecsegtetők, miközben felmerül, hogy az EU fontos területen szerez versenyképességi hátrányt. Természetesen csak utólag fogjuk megtudni, hogy a konfliktus feloldása a haladás és a közérdek (végső soron az ember) között sikeres volt-e ezekkel a szabályozási lépésekkel.

7. Az MI szabályozásának további sarokpontjai

Fenti etikai elvekből és a technológia szabályozás általános megfontolásaiból (a bizalomteremtés és elővigyázatosság elvéből) levezethetők az MI szabályozási követelményei: emberi felügyelet, technikai biztonság, magánszféra védelme, átláthatóság, tisztesség és diszkriminációmentesség, társadalmi és környezeti jólét, elszámoltathatóság.

Az EU Bizottság Fehér Könyve hangsúlyozza, hogy az MI fejlesztőinek és működtetőinek már most meg kell felelniük az adatvédelmi, magánszféra-védelmi, diszkriminációmentességi, fogyasztóvédelmi, termékbiztonsági és felelősségi elvárásoknak.[49] Pl. a GDPR már most is előírja a természetes személyek tájékoztatását, ha automatizált döntéshozatal alá esnek (amely MI alapú működés esetén is előfordulhat).[50] Az érintett személyeknek továbbá joguk van ahhoz, hogy tájékoztatást kapjanak az automatizált döntéshozatal létezéséről, illetőleg a magánszemélyeket az a jog is megilleti, hogy bizonyos helyzetek kivételével velük szemben ne kizárólag az automatizált döntéshozatalt alkalmazzák.[51] Ezenkívül a GDPR 9. cikke és a 2016/680/EU irányelv[52] 10. cikke elvárja, hogy biometrikus adatokat természetes személyek azonosítására az MI (pl. arcfelismerés, automatikus határellenőrzés) közérdekből, alapos indokkal és arányosan használjon fel, mert ez súlyosan érintheti az emberek alapjogait (pl. véleménynyilvánítás szabadsága, diszkrimináció tilalma terén).

Ugyanakkor vannak az MI-nek olyan tulajdonságai (a black box hatáson is túl) amelyek a jelenlegi szabályozási keretet kihívás elé állítják, ezért azt felül kell vizsgálni és szükség esetén ki kell egészíteni, hogy képes legyen az MI jelentette kockázatok hatékony kezelésére a megbízhatósági elv teljesülése érdekében.3[]

A tisztázására váró jogi problémák az EU Bizottság Fehér Könyve szerint például még az alábbi körülményekből fakadnak (a black box hatáson is túl):[54] megbízható, széleskörűen elérhető adattömeg; termékbiztonsági és kárfelelősségi szabályok.

7.1. Egységes európai adattér létrehozása

Lényeges, hogy az MI biztonsága a betáplált adatok minőségén múlik, ezért azoknak széles körűnek és relevánsnak kell lenniük,[55] biztosítaniuk kell hosszú távon az MI működésének diszkriminációmentességét és az adatvédelmet. Az adatok tehát meghatározóak az MI működése szempontjából.

Az EU versenytársai közül az USA az adattere kialakítását a magánszférára hagyta jelentős piaci koncentráltság mellett, míg Kínában ezen a téren az egyéni jogok védelmének figyelmen kívül hagyásával teljes állami felügyelet érvényesül.[56] Az EU olyan egységes adattér mellett teszi le a voksát, ahol az adatok szabad áramlása és védelme egyaránt biztosított.[57]

Miután az adatok nem versengő javak, így többször is felhasználhatók teljesen új szolgáltatások fejlesztésére is.[58] Ennek biztosítása érdekében már eddig is történtek EU-szinten ebben az irányba mutató jogalkotási lépések:

Az EU 2018. november 14-i 2018/1807 rendelete a nem személyes adatok Európai Unióban való szabad áramlásának keretéről[59] előírja; a tagállamoknak 24 hónapon belül felül kell vizsgálniuk a nemzeti adatlokalizációs korlátozásokat és közérdek hiányában el kell törölni a nem személyes adatok EU-n belüli áramlását akadályozó adatlokalizációs előírásokat, amelyek jellemzően abból a félelemből táplálkoznak, hogy majd így nem állnak a nemzeti hatóságok rendelkezésére.[60] Ez áthidalható úgy, ha a hozzáférési jogot megkapják a hatóságok függetlenül attól, hol van tárolva az adat. Például az ECN+ irányelv[61] alapján a nemzeti versenyhatóságoknak minden olyan adathoz hozzá kell férniük, amelyek az eljárás alá vont vállalkozások számára hozzáférhetők, függetlenül azok fizikai elhelyezkedésétől.

A 2019-es nyílt hozzáférési irányelv a közszféra információinak és a közpénzből finanszírozott információknak a széles körű, Unió-szerte történő további felhasználása miatt írja elő az akadályok elhárítását például éppen a mesterséges intelligencia további ösztönzése érdekében.[62]

A közadatok magáncélú felhasználásra megnyitására (G2B adatmegosztás) van tehát szabályozás, azonban ez visszafelé nincs és nem is igazán működik (a magánpiaci szereplők közt B2B adatmegosztás) vélhetően a bizalmatlanság és a versenyelőny elvesztésétől való félelem miatt, és ezt fontos kérdést a versenyjog sem tudja hatékonyan megoldani. Nem véletlen, hogy a brit Furman-jelentés[63] is ex-ante szabályozási kezelés mellett teszi le a voksát a digitális piacokon a verseny élénkítése (köztük az adatokhoz való hozzáférés előmozdítása) terén, mert a versenyjog lassú, nehézkes és megjósolhatatlan kimenetű. A Bizottság szakértői anyaga is hangsúlyozza, hogy a versenyjog és szabályozás egymást kiegészítő viszonyban van és a versenyjog hasznos háttértámogatás tud lenni a digitális gazdaság szabályozásának.[64]

Ehhez képest időnként felmerül, hogy a versenyjogot kellene tovább igazítani.[65] A francia versenyhatóság egyenesen azt javasolja, hogy a versenyjog alatt kell megteremteni annak lehetőségét, hogy az erőfölénnyel nem rendelkező, de meghatározó digitális platformok versenyellenes magatartását az interoperabilitás megteremtése és az adatokhoz való hozzáférés terén kezelni lehessen.[66] A franciák amúgy a német megoldáshoz hasonlóan annak hívei, hogy a fúziós küszöb alatti digitális összefonódások vizsgálatára is legyen versenyhatósági hatáskör. Ezt a Bizottság szakértői anyaga korainak tartja még EU-s szinten.[67]

A Bizottság tervezett 2021-es Adattörvénye a piaci szereplők közti (B2B) adatmegosztást önkéntes alapon ösztönözné, de bizonyos szektorok esetében akár kötelezővé is tenné FRAND (fair, reasonable, and non-discriminatory) alapon, ha a versenyjog nem lenne elégséges, mert mondjuk erőfölény hiánya esetén is korlátozná a fejlesztési versenyt a hozzáférések korlátozottsága.[68] Létezik már ilyen szektorális szabályozási előírás kötelező adatmegosztásra, például az autójavítás körében használatos egyes információk megosztásáról[69] vagy a pénzügyi szektorban.[70] A francia Loi Lemaire[71] amúgy a hozzáférési irányelvet tágan értelmezve adatmegosztásra kötelezi azokat a vállalatokat is, amelyek közérdekű adatokat birtokolnak, például közbeszerzésekkel ingatlanértékesítés, valamint a gáz- és a villamosenergia-fogyasztással kapcsolatos adatokat, hogy azok szabadon használhatók és harmadik fél által újrafelhasználhatók legyenek.

Azért lényeges az óvatosság és a differenciált megközelítés egyes szektorok és az adatok jelentősége mentén a kötelező adatmegosztással kapcsolatosan, mert az hátrányosan hathat az innovációra.[72]

Az igazsághoz hozzátartozik, hogy nemcsak a versenyjogot, de bizonyos vonatkozásaiban a GDPR-t is meghaladó szabályozásra van szükség a hatékonyan működő európai adattér kialakítása érdekében. Egyrészt a GDPR 4. cikk (2) bekezdése alapján az adatmegosztás is adatkezelésnek minősül, így csak a 6. cikk (1) bekezdésbe foglalt feltételekkel valósítható meg, különleges személyes adatok esetében pedig a követelmények a 9. cikk alapján még szigorúbbak. A jogbiztonság szempontjából így a GDPR-ra figyelemmel is (nemcsak versenyjog fenti korlátai miatt) kedvezőbb, ha az adatmegosztásnak törvényi alapja van, főleg, mert amúgy versenyjogi következményei is lehetnek. Az, hogy a GDPR nem elégséges az adatáramlás előmozdítása érdekében, már a bizottsági szakértő anyagban is felmerült az adathordozhatósággal összefüggésben, amely csak a múltbeli adatok vándorlására kínál megoldást de nem biztosítja a folyamatos adatmegosztást.[73] Továbbá megosztástechnikai feltételeinek kialakítása (interoperabilitás megteremtése) is igényli az ex-ante szabályozási beavatkozást.[74]

7.2. Termékbiztonsági és felelősségi kérdések az MI kapcsán

Az EU termékbiztonsági és felelősségi szabályai egymást kiegészítve biztosítják, hogy a kár bekövetkezésének esélye minimális legyen, illetve ha bekövetkezik, az kompenzálására kerüljön.[75]

Az EU termékbiztonsági szabályait még az MI előtt alkották, így például azok általában nem tartalmazzák a kibertámadások elleni alapvető követelményeket, miközben az MI egyik fő jellemzője (az online térbe kapcsoltság) miatt ez komoly fenyegetés.[76] Speciális eszközök (pl. orvosi, mérőeszközök, rádiós eszközök) esetében vannak biztonsági követelmények, de az EU Bizottság sürgeti az általános megerősítést is.[77] Az EU-s szabályok szintén megkövetelik a felhasználók biztonsági utasításokkal való ellátását a használattal összefüggésben felmerülő lehetséges kockázatok mentén. Ez az előreláthatóság azonban az MI esetében szintén hiányozhat, amire az MI működésnek folyamatos emberi felügyelete jelenthet megoldást amellett, hogy a frissítések kiadásakor a biztonságikockázat-felmérést el kell végezni és ezzel összefüggő tájékoztatást meg kell adni.[78] Miután az MI több olyan részből áll össze, amelyet különféle gyártók fejlesztettek, ezért a kockázatelemzés során ezen komponensek együttműködéséből fakadó kockázatokat (a részek egymásra hatását) is számba kell venni. Az MI komplexitása ellenére a termékbiztonsági felelősség annál a gyártónál marad, aki az adott terméket komponenseivel a piacra dobta.[79]

A fentiek során hivatkozott black box hatás miatt jogi szempontból tehát előfordulhat, hogy nem lesz humán felelőse az MI működésének és az így okozott károknak, amely nem egyeztethető össze a veszteségkompenzáció elvével.[80] Az EU termékfelelősségi szabályok és a nemzeti polgári jogi nem harmonizált vétkességi kárfelelősségi szabályok egymást kiegészítve működnek.[81] Az EU termékfelelősségi szabályai szerint[82] meg kell téríteni azt a kárt, amelyről a károsult bizonyítja, hogy termék hibájából következett be (nem teljesítette a tőle elvárható biztonságot) és azzal okozati összefüggésben neki kárt okozott. A nemzeti polgári jogok vétkességi elven nyugvó kárfelelőssége szerint felelős személy hibáját, a kárt és a kettő közötti okozati összefüggést kell bizonyítani. Ezt egészítheti ki nemzeti szinten szigorú felelősségi alakzat, amikor valamely elem bizonyítását nem követeli meg jog. Az MI számos tulajdonsága miatt azonban alááshatja ezeknek a felelősségi alakzatoknak a hatékony működését. Ilyen például az autonómia, ami miatt ha nem lehet visszavezetni a kárt emberre, akkor az sértheti a károsult kompenzálásának elvét. Ezt azonban kezelni kell, mert az MI elterjedéshez szükséges társadalmi bizalom kialakításának ez is kulcsa.[83]

Az első kérdés a felelősség kapcsán, hogy a jelenleg alkalmazott felelősségi alakzatok alkalmazhatók-e olyan technológiákra, mint az MI. Természetesen az MI-t nem lehet az emberhez vagy állathoz hasonlítani, azonban az autonómia lényeges jellemző, amely mindkét esetben releváns és kiemelkedő. A meghatározott biztonsági kereteken belül az MI önállóan és függetlenül, azaz felügyelet nélkül is képes önállóan működni. Az állatokért való felelősséggel kapcsolatos megközelítés a kiszámíthatatlanság fogalmához kapcsolódik, ami miatt az autonóm viselkedéssel összefüggésben is érdekes. A biztonsági előírások fontos szerepet játszanak ennek a kiszámíthatatlanságnak a társadalmilag elfogadott minimumra való csökkentésében. Jelenleg nem létezik az

MI-kre nézve objektív felelősségen alapuló koncepció, az hogy a felelősség vétkességi vagy objektív alapú legyen, alapvető kérdés.

Míg a vétkességi alapú felelősség azon az indokon alapul, hogy a jogsértő nem tartott be bizonyos követelményeket, az objektív felelősség arra az elgondolásra épít, hogy az a személy, aki miatt a kockázat előállt, felelősséggel tartozik minden kárért, ami ezzel a kockázattal összefüggésben következett be. A jelenlegi objektív felelősségi szabályok alkalmazhatók egyes MI alapú eszközökre, például az automatizált járművekre. Másik fontos kérdés a felelősség megállapításánál, hogy számít-e, és ha igen, milyen mértékben, hogy a kár bekövetkezése elkerülhető volt-e.

Az épületek összeomlása esetén például konkrét nemzeti felelősségi rendszerekben a törvény által felelősségre vonható bármely személy elkerülheti a felelősséget, ha bizonyítja, hogy mindent megtett a kár elkerülése érdekében, vagy kellő mértékű gondosságot tanúsítottak. Analógia alapján ez azt jelentené, hogy az MI tulajdonosa el tudná kerülni a felelősségre vonást, ha bizonyítaná, hogy megfelelően használta és tartotta karban az MI-t, figyelemmel a gyártó előírásaira, és frissítette a szoftvert, amikor az szükséges volt. Ugyanakkor ezek a technológiák még kifogástalan használat és karbantartás mellett is okozhatnak kárt, mivel autonóm módon működhetnek. Az autonóm jelleget figyelembe véve felmerül a kérdés, hogy egy felelősségre vonható személy milyen lépéseket tehet a feltörekvő technológia autonóm viselkedése által okozott kár elkerülése érdekében.[84]

Az Európai Parlament,[85] habár nem határoz meg ajánlásában konkrét felelősségi alakzatokat, szabályokat, néhány elvi jelentőségű megállapítást megfogalmaz. Talán a legfontosabb követelményként rögzíti a dokumentum a felelősség kizárásának a tilalmát, vagyis azt a szabályozási elvárást, miszerint „bármilyen jogi megoldást [választ a jogalkotó] a robotok által okozott károk iránti felelősségre vonatkozóan a vagyoni károktól eltérő esetekben, a jövőbeni jogalkotási aktus semmilyen körülmények között nem korlátozhatja a megtéríthető károk típusát és mértékét, illetve nem korlátozhatja a károsultnak felkínálható kártérítés formáit pusztán azon az alapon, hogy a kárt nem emberi lény okozta”.[86]

A bonyolult felelősségi viszonyok egy esetleges megoldásaként tekint az Európai Parlament állásfoglalása egy sajátságos, a robotok által okozott károk megtérítésére létrehozott kötelező biztosítási rendszer intézményesítésére. Ezt a kötelező robot-felelősségbiztosítást az EP állásfoglalása szerint ajánlatos lenne megtámogatni egy „kockázati” pénzalappal, amely azt a célt szolgálná, hogy az olyan káreseményeknél is legyen lehetőség a kár megtérítésére, amelyeknél nem áll rendelkezésre a szükséges mértékű biztosítási fedezet. Mivel a robotok gyártói, üzembentartói által kötött felelősségbiztosítás fedezné a robot által okozott károkat, így az ő felelősségük korlátozott lehet, amennyiben befizetnek egy kompenzációs alapba.

A feltörekvő digitális technológiák igen komplexek, az összetevők közötti interdependencia miatt, mert tartalmazhatnak a) fizikai részeket (pl. szenzorok, hardver), b) különböző szoftverelemeket, c) adatokat, d) adatfeldolgozási komponenseket.[87] Ez az interdependencia számos kérdést vet fel, pl. ki a felelős azért, ha egy technológia kárt okoz, vagy hogyan azonosítható a probléma gyökere (kiváltó oka). Amennyiben ezek az eszközök mozgatható elemeket tartalmaznak terméknek minősülve (a szoftverek tipikusan ezek), önállóan a Termékfelelősségi irányelv alá tartoznak.[88]

Nem újkeletű probléma, hogy egy termékbe a gyártó harmadik felek által készített részeket illeszt be, és a végső termék biztonságát a gyártónak kell biztosítania (függetlenül attól, hogy az harmadik fél alkatrészeit is tartalmazza). A digitális technológiákban azonban oly mértékű a különböző részek kapcsolata és olyannyira összetett, hogy a szabályozást át kell gondolni, hogy hatékony jogorvoslati lehetőséget nyújt-e a károsultnak, és kellő jogbiztonságot a gyártóknak. A Bizottság szerint megfontolandó a komplexitásból fakadó bizonytalanság csökkentése érdekében a nemzeti polgári jogokban a bizonyítási teher megfordítása.[89]

Ráadásul ezek a technológiák az autonómia jegyeit is hordozzák. Az önálló tanulással és autonómiával a technológiák viselkedése nehezen kiszámíthatóvá válhat, mely a felelősség kérdését veti fel, pl. ha a bizonyos fokú autonómiával cselekvő gép által okozott kár nem hibával vagy emberi visszaéléssel áll okozati összefüggésben. További kérdés, hogyan alakul a felelősség, ha technológia kimenetele nem volt azonosítható a termék piacra vezetése során. A digitális technológiai termékek ráadásul adatokat generálnak, illetve kezelnek. Működésük a bevitt adatoktól függ, és hibás adatok a rendszer rossz működéséhez vezethetnek.

Megfontolandó az MI kapcsán a szigorú felelősségi szabályok alkalmazása, ahol a felelősség a működtető személyé. A károsultnak ezért csak azt kellene bizonyítania, hogy az MI okozta a kárt, anélkül hogy azt kellene alátámasztania, hogy ez pontosan mire is volt visszavezethető. Másik megoldás, ha a károsult az általános nemzeti kártérítési jog alapján is benyújthatná kárigényét a működtető ellen, ez esetben a működtető hibáját is bizonyítani kellene. További lehetőség, ha a károsult a termékfelelősségi irányelvet implementáló nemzeti jog alapján felelősségre vonhatná a gyártót. Ekkor bizonyítania kellene az MI hibáját és azt, hogy a kárt a termék hibája okozta.

Az egyik legfontosabb MI alkalmazás az autonóm járművekhez kapcsolódik. A közúti balesetek számának drámai csökkenését, alacsonyabb utazási időt, környezetvédelmi hatásokat várnak tőle. Vannak félautonóm járművek, amelyeknél az autó a vezető felügyelete alatt működik, ahol a vezető a felelős az autóért, és készen kell állnia, hogy átvegye a kontrollt a kocsi felett, ha szükséges vagy ha az jelzi. Vannak olyan teljesen autonóm járművek, amelyek minden körülmény között, bármilyen úton képesek működni minden emberi beavatkozás nélkül. Egyelőre kevés országban fogadtak el az autonóm járművekre jogszabályokat. Ezért egyelőre a gépjárművekre irányadó nemzeti polgári jogi szabályok vehetők alapul.

A Gépjármű-biztosítási irányelv[90] alapján minden tagállamban kötelező a gépjárművek felelősségbiztosítása, amelyekből a károsult közvetlen kárigénnyel kérhet kártérítést a biztosítótól. Ha a balesetet egy teljesen autonóm jármű okozza, a polgári jogi felelősségi szabályok alapján a jármű tulajdonosa/vezetője vagy a termékfelelősségi irányelv alapján az autonóm jármű gyártója között osztható meg a felelősség. Az előbbi esetben vétkességi alapú (általában a vezetővel szemben van ilyen, a vezető hibáját feltételezi mindaddig, amíg nem bizonyítja az ellenkezőjét) vagy kockázat alapú (ekkor szigorú felelősségi szabályok érvényesülnek, általában az autó tulajdonosával szemben van ilyen) a felelősség. Ha a kocsi tulajdonosa a felelős az objektív felelősségi szabályok alapján, akkor nem kell bizonyítani az autó hibáját vagy a vezető mulasztását. Ha a károsult a gyártót pereli a termékfelelősségi irányelv alapján, akkor bizonyítania kell a kocsi hibáját és a kár és a hiba közötti okozati kapcsolatot. Háttérben pedig ott van a kötelező felelősségbiztosítás, amelyből a károsult közvetlen a biztosítóhoz fordulva érvényesítheti kárát a Gépjármű-biztosítási irányelv alapján. 2018. március 19-én az Uber teljesen autonóm járműve halálra gázolt egy gyalogost Arizonában. A kocsi teljes autonóm üzemmódban volt, és benne ült a „kezelő”. Az ügyészi indítvány szerint az Ubert azonban nem terheli büntetőjogi felelősség az ügyben, szemben a vezetővel, aki épp tévét nézett a kocsiban ahelyett, hogy az útra figyelt volna.[91]

8. Összegzés

Jelen tanulmányban az MI szabályozásának paradoxonjával és egyes alapvető szabályozási kérdéseivel foglalkoztam. Az MI szabályozási paradoxonja abból fakad, hogy miközben az MI egyik legfőbb kihívása a kiszámíthatatlanságából fakad (black box hatás) addig szabályozási oldalról bízunk abban, hogy ez kiküszöbölhető. Az ismeretlen technológiákkal szembeni legnagyobb kihívás ugyanis a bizalom megerősítése és ebből a szempontból szabályozási paradoxonról beszélhetünk egy eleve nem megbízható ismeretlen technológia kapcsán. Bemutattam, hogy egyfelől le kell tenni arról, hogy van 100%-os biztonság, továbbá, hogy az MI jelentette társadalmi előnyök is kecsegtetők, ami miatt nagy a veszélye, hogy az EU fontos területen veszít versenyképességéből, ha a teljes tiltást választaná. Kitértem arra, hogy az elővigyázatossági elv olyan alkalmazása lehet a célravezető, amely a tudományosan feltételezett kockázatokat megvizsgálja abból a szempontból, hogy szabályozási eszközökkel megnyugtató kiküszöbölhetők-e. Az EU Bizottság Fehér Könyvében javasolt kockázat alapú megközelítés és ebből fakadó előzetes engedélyezés és folyamatos emberi felügyelet (ideértve az MI-n alapuló döntéshozatali jóváhagyást is) előremutató lehet. A szabályozási paradoxont jelentő black box hatáson túl foglalkoztam az MI megfelelő működésének olyan jogi vonatkozásaival, mint az egységes európai adattér létrehozása vagy a károsultak kompenzálásának elvét és az innováció védelmét is tiszteletben tartó kárfelelősségi és termékfelelősségi szabályok kialakítása.

[1] An Open Letter to the United Nations Convention on Certain Conventional Weapons. Elérhető: https://www.dropbox.com/s/g4ijcaqq6ivq19d/2017%20Open%20Letter%20to%20the%20United

%20Nations%20Convention%20on%20Certain%20Conventional%20Weapons.pdf?dl=0.

[2] Scherer, Matthew U.: Regulating Artificial Intelligence Systems: Risks, Challenges, Competencies, and Strategies (May 30, 2015). Harvard Journal of Law & Technology, Vol. 29, No. 2, Spring 2016., 359. (a továbbiakban: Scherer).

[3] Sturat J. Russle – Peter Norvig: Artificial Intelligence, Modern Approach, 1034 (3d ed. 2010).

[4] A. M. Turing: Computing Machinery and Intelligence, 59 MIND 433, 442 (1950).

[5] Scherer, 361.

[6] Communication from the Commission to European Parliament, European Council, the Council, the European Economic and Social Committee, the Committee of the Regions on Artificial Intelligence for Europe, Brussels, 25.4.2018 COM(2018) 237 final. 1. https://ec.europa.eu/transparency/regdoc/rep/1/2018/EN/COM-2018-237-F1-EN-MAIN-PART-1.PDF (a továbbiakban: Bizottság MI Közleménye).

[7] Bizottság MI Közleménye 1.

[8] Gaszt Csaba: A mesterséges intelligencia szabályozási kérdései, különös tekintettel a robotikára, Infokommunikáció és jog, 2019/1., 21–22.

[9] Raymond H. Brescia: Uber for Lawyers: The Transformative Potential of a Sharing Economy Approach to the Delivery of Legal Services. 64 Buffalo Law Review. 2016. 5.

[10] Andrew Sullivan: Law and technology – new oppurtunities for lawyers and their clients. 27 March 2015, (draft). https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2648538.

[11] Bizottság MI Közleménye 12.

[12] European Commission: White Paper on Artificial Intelligence – A European approach to excellence and trust, Brussels, 19.2.2020 COM(2020)65 final, 2. (a továbbiakban: Fehér Könyv).

[13] A Bizottság közleménye az Európai Parlamentnek, a Tanácsnak, az Európai Gazdasági és Szociális Bizottságnak és a Régiók Bizottságának: Az emberközpontú mesterséges intelligencia iránti bizalom növelése. (a továbbiakban: Bizottság MI Bizalom Közleménye) Brüsszel, 2019.4.8. COM(2019) 168 final. 1.

https://eur-lex.europa.eu/LexUriServ/LexUriServ.douri=COM:2019:0168:FIN:HU:PDF.

[14] Fehér Könyv 1.

[15] Bizottság MI Bizalom Közleménye, 2–3.

[16] Bizottság MI Közleménye, 4.

[17] Bizottság MI Közleménye, 6.

[18] Fehér Könyv, 1.

[19] Bizottság MI Közleménye 14–15.

[20] Uo. 17.

[21] Alan Beattie: Technology: how the US, EU and China compete to set industry standards. 2019. július 24. https://www.ft.com/content/0c91b884-92bb-11e9-aea1-2b1d33ac3271.

[22] Fehér Könyv, 10.

[23] Bizottság Közleménye, a közösségi gazdaságra vonatkozó európai menetrend {SWD(2016) 184 final} Brüsszel, 2016.6.2. COM(2016) 356 final, 3.

[24] Tóth András: Jog és technológia, , In. Technológia jog – Robotjog – Cyberjog, Wolters Kluwer Hungary Kft., Budapest, 2018. Szerkesztette: Klein Tamás – Tóth András, Wolters Kluwer Hungary Kft., Budapest, 2018.

[25] Scherer, 365.; Commission Report on safety and liability implications of AI, the Internet of Things and Robotics, Brussels, 19.2.2020 COM(2020)64 final, 15. (a továbbiakban: Bizottsági Jelentés).

[26] Gregory N. Mandel: Regulating emerging technologies, 2009.

[27] Kieran Tranter: Nomology, Ontology and Phenomenology of Law and Technology, 8 Minn. J. L. SCI. & Tech.. 449 (2007).

[28] European Parliament resolution of 16 February 2017 with recommendations to the Commission on Civil Law

Rules on Robotics (2015/2103(INL)) European Civil Law

Rules in Robotics – Study, 6. Elérhető: http://www.europarl.europa.eu/RegData/etudes/STUD/2016/571379/IPOL_STU(2016)571379_EN.pdf 10 (a továbbiakban: EP Study).

[29] EP Study, 6.

[30] Az EU környezetvédelmi politikája a Riói Nyilatkozatra való hivatkozással szentesítette ezt az elvet, eszerint amikor komoly és visszafordíthatatlan károkozás veszélye áll fenn, akkor a teljes tudományos bizonyosság hiánya nem lehet az oka a környezetszennyezést megakadályozó költséghatékony intézkedések alkalmazásának. Esther Versluis – Marjolein van Asselt – Tessa Fox – Anique Hommels: Calculable Risks? An Analysis of the European Seveso Regime, in. Dimension of technology Regulations, eds.: Morag Goodwin – Bert-Jaap Koops – Ronald Leenes – Wolf Legal Publishers, 2010.

[31] Jonathan B. Wiener: The regulation of technology, and the technology of regulation, Technology in society 26 (2004), 495. o.

[32] T-13/99

[33] Wolfgang van den Daele: Access to New Technology. In Defense of the Liberal Regime of Innovation, 85. o., in. Dimension of technology Regulations, eds.: Morag Goodwin – Bert-Jaap Koops – Ronald Leenes – Wolf Legal Publishers, 2010.

[34] Esther Versluis – Marjolein van Asselt – Tessa Fox, Anique Hommels: Calculable Risks? An Analysis of the European Seveso Regime, in. Dimension of technology Regulations, eds.: Morag Goodwin, Bert-Jaap Koops, Ronald Leenes, Wolf Legal Publishers, 2010.

[35] Wiener i. m., 484.

[36] Az Európai Bizottság által 2018 júniusában létrehozott, mesterséges intelligenciával foglalkozó magas szintű független szakértői csoport megbízható mesterséges intelligenciára vonatkozó etikai iránymutatása. Brüsszel, 2019. április. 14. https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=60429.

[37] EP Study, 20.

[38] EP Study, 21.

[39] Petit, Nicolas, Law and Regulation of Artificial Intelligence and Robots – Conceptual Framework and Normative Implications (March 9, 2017) 3. https://papers.ssrn.com/sol3/papers.cfm?abstract_id=2931339.

[40] EP Study, 20.

[41] EP Study, 22.

[42] Scherer, Matthew U., Regulating Artificial Intelligence Systems: Risks, Challenges, Competencies, and Strategies (May 30, 2015). Harvard Journal of Law & Technology, Vol. 29, No. 2, Spring 2016., 363.

[43] Scherer, 364.

[44] Fehér Könyv, 17.

[45] Fehér Könyv, 17.

[46] Fehér Könyv, 23.

[47] Bizottsági Jelentés, 9.

[48] Fehér Könyv, 21.

[49] Fehér Könyv, 10.

[50] Vö. Az Európai Parlament és a Tanács (EU) 2016/679 rendelete (2016. április 27.) a természetes személyeknek a személyes adatok kezelése tekintetében történő védelméről és az ilyen adatok szabad áramlásáról, valamint a 95/46/EK rendelet hatályon kívül helyezéséről (általános adatvédelmi rendelet), OJ L 119, 2016. 05. 04., 1–88.

(GDPR) 13. cikk (2) bek. f) pont.

[51] GDPR 22. cikk.

[52] Directive (EU) 2016/680 of the European Parliament and of the Council of 27 April 2016 on the protection of natural persons with regard to the processing of personal data by competent authorities for the purposes of the prevention, investigation, detection or prosecution of criminal offences or the execution of criminal penalties, and on the free movement of such data, and repealing Council Framework Decision 2008/977/JHA OJ L 119, 4.5.2016, p. 89–131.

[53] Fehér Könyv, 10.

[54] Fehér Könyv, 14.

[55] Fehér Könyv, 19. és Bizottsági Jelentés, 9.

[56] Communication from the Commission to European Parliament, European Council, the Council, the European Economic and Social Committee, the Committee of the Regions, A European strategy for data, Brussels, 19.2.2020 COM(2020) 66 final, 3. (EU Adat Stratégia).

[57] EU Adat Stratégia, 3.

[58] European Commission, ‘Guidance on Private Sector Data Sharing | Digital Single Market’ https://ec.europa.eu/digital-single-market/en/guidance-private-sector-data-sharing – accessed 12 November 2018.

[59] Az Európai Parlament és a Tanács (EU) 2018/1807 rendelete (2018. november 14.) a nem személyes adatok Európai Unióban való szabad áramlásának keretéről

[60] Regulation (EU) 2018/1807 of the European Parliament and of the Council of 14 November 2018 on a framework for the free flow of non-personal data in the European Union

[61] Directive (EU) 2019/1 of the European Parliament and of the Council of 11 December 2018 to empower the competition authorities of the Member States to be more effective enforcers and to ensure the proper functioning of the internal market b) pont és 8. cikk.

[62] Az Európai Parlament és a Tanács (EU) 2019/1024 irányelve (2019. június 20.) a nyílt hozzáférésű adatokról és a közszféra információinak további felhasználásáról

[63] Jason Furman et al: ‘Unlocking Digital Competition’ (2019) 84 https://assets.publishing.service.gov.uk/government/uploads/system/uploads/attachment_data/file/785547/

unlocking_digital_competition_furman_review_web.pdf 6.

[64] Jacques Crémer – Yves-Alexandre de Montjoye – Heike Schweitzer: European Commission: Competition Policy for the digital era (final report, 2019), 5.

[65] Sebastian Felix Janka – Severin Benedict Uhsler: Antitrust 4.0 – the rise of Artificial Intelliegence and emerging

[66] https://www.autoritedelaconcurrence.fr/fr/communiques-de-presse/lautorite-publie-sa-contribution-au-debat-sur-la-politique-de-concurrence.

[67] Jacques Crémer – Yves-Alexandre de Montjoye – Heike Schweitzer: European Commission: Competition Policy for the digital era (final report, 2019), 10.

[68] EU Adat Stratégia, 14.

[69] Regulation (EC) No 715/2007 of the European Parliament and of the Council of 20 June 2007 on type approval of motor vehicles with respect to emissions from light passenger and commercial vehicles (Euro 5 and Euro 6) and on access to vehicle repair and maintenance information,

[70] Directive 2015/2366/EU of the European Parliament and of the Council of 25 November 2015 on payment services in the internal market, amending Directives 2002/65/EC, 2009/110/EC and 2013/36/EU and Regulation (EU) No 1093/2010, and repealing Directive 2007/64/EC,

[71] Loi n° 2016-1321 pour une République numérique.

[72] Dutch Vision on Data Sharing between Businesses’ (2019) https://www.government.nl/documents/reports/2019/02/01/dutch-vision-on-data-sharing-between-businesses.

[73] Jacques Crémer – Yves-Alexandre de Montjoye – Heike Schweitzer: European Commission: Competition Policy for the digital era (final report, 2019), 8.

[74] Jacques Crémer – Yves-Alexandre de Montjoye – Heike Schweitzer: European Commission: Competition Policy for the digital era (final report, 2019), 9.

[75] Bizottsági Jelentés, 12.

[76] Bizottsági Jelentés, 6.

[77] Bizottsági Jelentés, 6.

[78] Bizottsági Jelentés, 8.

[79] Bizottsági Jelentés, 11.

[80] Scherer, (lj. 65.) 365.

[81] Bizottsági Jelentés, 12.

[82] 85/374/EEC Irányelv

[83] Bizottsági Jelentés, 13.

[84] Bizottság MI Közleménye, 19.

[85] Az Európai Parlament 2017. február 16-i állásfoglalása a Bizottságnak szóló ajánlásokkal a robotikára vonatkozó polgári jogi szabályokról. http://www.europarl.europa.eu/doceo/document/TA-8-2017-0051_HU.html?redirect (a továbbiakban: EP Állásfoglalás).

[86] EP Állásfoglalás 52. pont.

[87] Liability for emerging digital technologies. Communication from the Commission to the European Parliament, the European Council, the Council, the European Economic and Social Committee and the Committee of the Regions Artificial intelligence for Europe. https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=51633.

[88] Uo. 9. o.

[89] Bizottsági Jelentés, 14.

[90] 2009/103/EC.

[91] https://www.npr.org/2019/03/06/700801945/uber-not-criminally-liable-in-death-of-woman-hit-by-self-driving-car-says-prosec.